یادگیری ماشین پیشرفته: غلبه بر پیچیدگی با مدلهای نوین و بهینهسازی هایپرپارامترها

یادگیری ماشین (Machine Learning – ML) به حوزهای پویا تبدیل شده که به کامپیوترها اجازه میدهد بدون برنامهریزی صریح، از دادهها یاد بگیرند و وظایف خاصی را انجام دهند. در حالی که مفاهیم پایه ML مانند رگرسیون خطی یا درخت تصمیم مسائل نسبتاً ساده را حل میکنند، دنیای واقعی پر از دادههای پیچیده مانند تصاویر، متون، صدا و سریهای زمانی نامنظم است که نیاز به مدلهایی بسیار قدرتمندتر و پیچیدهتر دارد. اینجاست که حوزه یادگیری ماشین پیشرفته وارد میشود، جایی که مدلها قادر به کشف الگوهای انتزاعی و پیچیده در دادههای بزرگ و متنوع هستند. در این سطح از یادگیری ماشین، درک مدلهای پیچیده و نقش حیاتی هایپرپارامترها اهمیتی دوچندان پیدا میکند.

مدلهای پیچیده در یادگیری ماشین پیشرفته:

مدلهای پیشرفته ML، برخلاف مدلهای سنتی که ساختار نسبتاً سادهای دارند، دارای معماریهای لایهلایه و درهمتنیدهای هستند که به آنها اجازه میدهند ویژگیهای (Features) سطح بالا را به تدریج از دادههای خام استخراج کنند. مهمترین دسته از این مدلها، شبکههای عصبی (Neural Networks) و به خصوص یادگیری عمیق (Deep Learning) هستند.

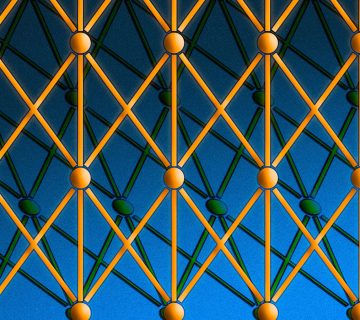

- شبکههای عصبی: این مدلها از واحدهای پردازشی ساده (نورونها) تشکیل شدهاند که به صورت لایهای به هم متصل شدهاند. هر نورون ورودیها را دریافت، پردازشی روی آنها انجام داده و خروجی را به نورونهای لایه بعدی ارسال میکند.

- یادگیری عمیق: زیرشاخهای از شبکههای عصبی است که از چندین لایه پنهان (Hidden Layers) بین لایه ورودی و خروجی استفاده میکند. وجود این لایههای متعدد به مدل اجازه میدهد تا انتزاعات و الگوهای بسیار پیچیده و سلسله مراتبی را در دادهها یاد بگیرد.

- شبکههای عصبی کانولوشنال (CNNs – Convolutional Neural Networks): برای پردازش دادههای شبکهای مانند تصاویر عالی هستند و به طور خودکار ویژگیهای بصری را استخراج میکنند.

- شبکههای عصبی بازگشتی (RNNs – Recurrent Neural Networks) و LSTMها (Long Short-Term Memory): برای پردازش دادههای دنبالهای مانند متن و سریهای زمانی طراحی شدهاند و میتوانند وابستگیهای زمانی را مدل کنند.

- ترانسفورمرها (Transformers): معماریهای جدیدتر و بسیار قدرتمندی هستند که به ویژه در پردازش زبان طبیعی (NLP) و اخیراً در بینایی ماشین انقلاب ایجاد کردهاند.

علاوه بر شبکههای عصبی عمیق، روشهای دیگری مانند روشهای Ensemble پیشرفته (مانند Gradient Boosting با الگوریتمهایی مثل XGBoost یا LightGBM) نیز در دسته مدلهای پیچیده قرار میگیرند که با ترکیب نتایج چندین مدل ضعیفتر، به عملکردی قویتر و مقاومتر دست مییابند.

این مدلها دارای میلیونها یا حتی میلیاردها پارامتر (مانند وزنها و بایاسهای اتصالات بین نورونها) هستند که مقادیر آنها در حین فرآیند آموزش با استفاده از دادهها یاد گرفته میشود.

هایپرپارامترها (Hyperparameters): کلید تنظیم مدل

در کنار پارامترهای مدل که به صورت خودکار یاد گرفته میشوند، مجموعهای از هایپرپارامترها وجود دارند که مقادیر آنها توسط متخصص یادگیری ماشین و قبل از شروع فرآیند آموزش تعیین میشود. هایپرپارامترها مستقیماً نحوه عملکرد الگوریتم یادگیری و ساختار مدل را تحت تاثیر قرار میدهند، اما خودشان توسط الگوریتم از روی دادهها یاد گرفته نمیشوند.

نمونههایی از هایپرپارامترهای رایج:

- نرخ یادگیری (Learning Rate): گامی که مدل در هر تکرار آموزش برای بهروزرسانی پارامترهایش برمیدارد. نرخ یادگیری نامناسب میتواند باعث عدم همگرایی یا واگرایی فرآیند آموزش شود.

- تعداد لایهها و تعداد نورونها در هر لایه: در شبکههای عصبی، این پارامترها مستقیماً معماری مدل را تعریف میکنند.

- تابع فعالسازی (Activation Function): تابعی که خروجی هر نورون را تعیین میکند (مانند ReLU, Sigmoid, Tanh).

- اندازه بچ (Batch Size): تعداد نمونههای داده که در هر تکرار آموزش برای محاسبه گرادیان استفاده میشوند.

- تعداد دورههای آموزش (Number of Epochs): تعداد دفعاتی که کل مجموعه داده آموزشی به مدل نمایش داده میشود.

- قدرت منظمسازی (Regularization Strength): پارامترهایی که برای جلوگیری از بیشبرازش (Overfitting) استفاده میشوند.

- اندازه کرنل (Kernel Size) یا تعداد فیلترها: در شبکههای عصبی کانولوشنال.

- تعداد درختها یا عمق آنها: در روشهای Ensemble مبتنی بر درخت مانند Random Forest یا Gradient Boosting.

اهمیت هایپرپارامترها:

انتخاب صحیح هایپرپارامترها برای موفقیت مدلهای پیچیده حیاتی است. هایپرپارامترهای نامناسب میتوانند منجر به مشکلات جدی شوند:

- بیشبرازش (Overfitting): مدل روی دادههای آموزشی عملکرد عالی دارد اما روی دادههای جدید (دادههای تست) ضعیف عمل میکند، زیرا جزئیات نویز و بیاهمیت در دادههای آموزشی را نیز یاد گرفته است.

- کمبرازش (Underfitting): مدل حتی روی دادههای آموزشی نیز عملکرد ضعیفی دارد، زیرا نتوانسته الگوهای لازم در دادهها را یاد بگیرد.

- عدم همگرایی: فرآیند آموزش به درستی پیش نمیرود و مدل به یک راهحل پایدار نمیرسد.

هایپرپارامترها تعیین میکنند که مدل چقدر قدرتمند باشد، با چه سرعتی یاد بگیرد و چقدر خوب بتواند یافتههایش را به دادههای جدید تعمیم دهد.

بهینهسازی هایپرپارامترها (Hyperparameter Tuning):

از آنجایی که هایپرپارامترها به صورت خودکار یاد گرفته نمیشوند و تاثیر چشمگیری بر عملکرد مدل دارند، فرآیند یافتن بهترین ترکیب از مقادیر آنها که منجر به بهترین عملکرد مدل روی دادههای دیده نشده (Validation Set) میشود، بهینهسازی هایپرپارامترها نامیده میشود. این فرآیند اغلب آزمایشی است و نیازمند تکنیکهای خاصی است:

- تنظیم دستی (Manual Tuning): متخصص ML با تجربه و شهود خود، مقادیر هایپرپارامترها را حدس میزند و عملکرد مدل را ارزیابی میکند. این روش بسیار زمانبر و ناکارآمد است.

- جستجوی شبکهای (Grid Search): تعریف یک محدوده از مقادیر ممکن برای هر هایپرپارامتر و تست تمام ترکیبهای ممکن از این مقادیر. این روش جامع است اما از نظر محاسباتی بسیار پرهزینه است، به خصوص وقتی تعداد هایپرپارامترها زیاد باشد.

- جستجوی تصادفی (Random Search): به جای تست تمام ترکیبها، مقادیر هایپرپارامترها به صورت تصادفی از محدودههای تعریف شده نمونهبرداری و تست میشوند. این روش اغلب در زمان کمتری نسبت به Grid Search به نتایج خوب میرسد.

- بهینهسازی بیزی (Bayesian Optimization): با استفاده از مدلهای احتمالی، فضای جستجوی هایپرپارامترها به صورت هوشمندانهتری کاوش میشود تا بهترین ترکیب با انجام آزمایشهای کمتری پیدا شود.

- AutoML: پلتفرمها و ابزارهای سطح بالاتری که فرآیند بهینهسازی هایپرپارامترها (و حتی انتخاب مدل و مهندسی ویژگی) را خودکارسازی میکنند.

نکته حیاتی در بهینهسازی هایپرپارامترها، استفاده از یک مجموعه داده اعتبارسنجی (Validation Set) مجزا است که نه بخشی از دادههای آموزشی و نه بخشی از دادههای تست نهایی باشد. هایپرپارامترها بر اساس عملکرد مدل بر روی دادههای اعتبارسنجی تنظیم میشوند تا از بیشبرازش هایپرپارامترها بر روی دادههای آموزشی جلوگیری شود. عملکرد نهایی مدل تنها پس از اتمام فرآیند بهینهسازی، بر روی مجموعه داده تست ارزیابی میشود.

نتیجهگیری:

یادگیری ماشین پیشرفته متکی بر مدلهای پیچیدهای است که میتوانند الگوهای پیچیده و انتزاعی را در دادهها کشف کنند. اثربخشی و عملکرد نهایی این مدلها به شدت به انتخاب صحیح و بهینهسازی هایپرپارامترها وابسته است. هایپرپارامترها پارامترهایی هستند که خارج از فرآیند یادگیری مدل تعیین میشوند و نقش آنها تنظیم دقیق نحوه آموزش و ساختار مدل برای دستیابی به بهترین تعمیمپذیری بر روی دادههای جدید است. تسلط بر تکنیکهای بهینهسازی هایپرپارامترها، مهارتی اساسی برای هر متخصص یادگیری ماشین در سطح پیشرفته است که به دنبال ساخت مدلهای قدرتمند و قابل اعتماد برای حل مسائل پیچیده دنیای واقعی است.

برنامهنویسی چیست؟ چرا برنامهنویسی یاد بگیریم؟

بینایی ماشین (Computer Vision): تشخیص و پردازش تصویر

پردازش زبان طبیعی (Natural Language Processing – NLP): تحلیل متن

بدون دیدگاه